ILA-DA:Improving Transferability of Intermediate Level Attack with Data Augmentation (ICLR 2023)

代码:https://github.com/argenycw/ILA-DA

主要方法

本文对ILA攻击进行完善,提出三个方法提高ILA

- 一种自动有效图像增广方法

- 一种有效的反向对抗更新技术

- 一个生成迁移性更强的攻击插值方法

自动有效图像增广方法

作者将增广选择过程\(T_z\)建模为从分布\(p_{\alpha}(z)\)中抽样,并使用公式中的可学习参数向量α: \[ T_z(x) = \sum_{i=1}^k z_i \varphi_i(x),\quad z \sim p_{\alpha}(z) \] z是one-hot向量,代表从有k个增广的集合\(\{\varphi_i(x)\}_{i=1}^k\)中的选择,作者使用Gumbel-Softmax重参数化技巧将离散增广分布松弛为连续的。在此过程中,利用随机梯度下降和学习权重参数\(\eta\)来优化目标,\(z_i\)松弛为: \[ \mathbf{z}_i=f _{\alpha_i}\left(g_i\right)=\frac{\exp \left(\left(\log \alpha_i+g_i\right) / \tau\right)}{\sum_{j=1}^k \exp \left(\left(\log \alpha_j+g_j\right) / \tau\right)} \] 其中\(g_i = -\log(-\log(u_i))\)是第\(i\)个随机Gumbel变量,\(u_i\)是均匀随机变量,\(\tau\)是温度系数。本文只考虑三种数据增广方法:平移,裁剪,旋转。

反向对抗更新技术

为了实现ILA,需要获得参考攻击\(x^{\prime}\)和未扰动图像\(x\)之间的特征图差异。尽管x被模型正确分类,但没有关于模型有多自信以及输入能在多大程度上代表ground-truth类的信息。相比之下,如果\(x\)不仅被正确分类,而且具有很高的置信度,则特征图的差异预计将从本质上反映关于攻击的更多有用信息。

为了提高x的置信度,作者建议对其添加一个负摄动,这与应用对抗性攻击完全相反。该操作预计将减少分类器的损失,通过强调对任务更重要的特征,使分类任务更容易。因此,作者也希望输入能够高度激活中间层,为ILA中的图像更新提供更好的指导。

作者从现有的参考攻击\(x^{\prime}\)中提取扰动,而不是制造一个新的对抗性攻击,因为新的攻击会引起额外的计算,将变换表示为: \[ T_{\mathrm{adv}}(\mathbf{x})=\mathbf{x}-\left(\mathbf{x}^{\prime}-\mathbf{x}\right)=2 \mathbf{x}-\mathbf{x}^{\prime} \]

生成迁移性更强的攻击插值方法

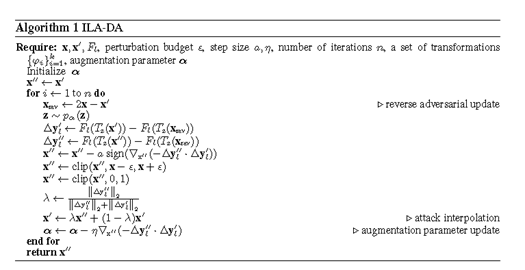

除了干净的图像\(x\)之外,参考攻击\(x^{\prime}\)是在所有ILA迭代中保持不变的另一个因素。但从直觉上来说,参考攻击越强,ILA性能越好。作者在ILA迭代过程中加强参考攻击的效果,方法是在参考攻击本身内插值生成更强的攻击。前一次迭代的输出\(x^{\prime \prime}\)是强攻击的一个很好的候选者。在迭代\(t\),有 \[ \mathbf{x}_{t+1}^{\prime}=\lambda \mathbf{x}_t^{\prime \prime}+(1-\lambda) \mathbf{x}_t^{\prime} \] 其中\(\lambda\)是范围[0,1]中的权重因子,用于控制两种攻击的比例。经过作者初步发现,将\(\lambda\)设置为常数,如0.5足以产生令人满意的性能。然而,设置为常数缺乏对这两种攻击行为的考虑,作者根据\(x_t^{\prime \prime}\)设计一种自适应方法,如果\(x_t^{\prime \prime}\)在一次更新后很弱,\(\lambda\)应该倾向于保留参考攻击,而不是与新的攻击混合。由于ILA侧重于最大化特征图差异之间的线性投影,因此特征图差异的范数可以很好地反映性能。因此,设计\(\lambda\)为: \[ \lambda=\frac{\left\|\Delta \mathbf{y}_{l}^{\prime \prime}\right\|_{2}}{\left\|\Delta \boldsymbol{y}_{l}^{\prime \prime}\right\|_{2}+\left\|\Delta y_{l}^{\prime}\right\|_{2}} \] 算法整个流程:

实验

实验很全面,有兴趣的可以看原文。